Nederlands onderzoek naar de effecten van koud douchen rammelt aan alle kanten

Het onderzoek, geïnspireerd door Wim Hof, stamt uit 2015 en wordt nog altijd volop aangehaald in de media

In deze nieuwsbrief wil ik een onderzoek uitlichten dat vaak wordt gebruikt als argument in de discussie over blootstelling aan kou. Het is hier te lezen.

Het is een onderzoek uit 2015, van het Amsterdam Medisch Centrum, waarbij drieduizend deelnemers, die zichzelf online konden aanmelden, werden opgedeeld in vier groepen. De ene groep douchte een maand lang dagelijks 30 seconden koud af, de andere 60 seconden, de derde groep 90 seconden (deze drie groepen vormen samen de zogeheten interventiegroep) en de vierde groep, de controlegroep, douchte niet koud af. Dit deden ze een maand lang, waarbij ze 90 dagen lang, dus tot 60 dagen na het koude douchen, vragenlijsten invulden over hun gesteldheid en ziekteverzuim.

De resultaten: door koud af te douchen, ongeacht hoe lang, is het ziekteverzuim 29 procent minder. Technisch gezegd: de incidentieratio was 0,71 met een p-waarde van 0,003.

Er was geen significant verschil gevonden in het aantal dagen dat men zich ziek voelde. Het onderzoek is gepeerreviewed en gepubliceerd in PLOS ONE, een prima medisch tijdschrift. Tot zover niks vreemds.

Onlangs werd ik echter gemaild door Joop Adema, een PhD-student. Hij is econoom en zag dat vooral in de gepubliceerde onderzoeksdata een en ander niet klopt. Daarom is hij van mening dat het paper zou moeten worden teruggetrokken.

Ik heb zijn kritiekpunten doorgenomen en heb ook medici geraadpleegd, die in grote lijnen het onderzoek ook vonden rammelen. In deze nieuwsbrief ga ik stap voor stap Adema’s kritiekpunten na, uiteraard met zijn goedkeuring.

Adema zelf heeft twee jaar geleden al het medische journaal, PLOS ONE, gemaild. Hem werd reactie beloofd, maar sindsdien is er radiostilte. Zelf heb ik het AMC benaderd, waar het onderzoek is uitgevoerd, en werd verzocht de onderzoekers te benaderen. De hoofdonderzoeker, Geert Alexander Buijze, is echter niet bereikbaar voor commentaar.

Impact

Het onderzoek heeft een niet te onderschatten impact op het debat over de gezondheidsvoordelen van blootstelling aan kou en in het verlengde daarvan de Wim Hof-methode. Sterker nog, toen ik eerder kritisch schreef over Wim Hof haalde ik zelf dit onderzoek aan om te benadrukken dat minieme blootstelling aan kou wel degelijk voordelen heeft. Zelfs ik legde het dus op de weegschaal en ik ben toch een van de grootste criticasters van Wim Hof en zijn strapatsen.

Maar ik niet alleen, ook grote internationale media die schrijven over koudetherapie, zoals New York Post, halen nog altijd het onderzoek aan. Ook Nederlandse mediamerken noemen het onderzoek nog regelmatig, om de voordelen van koud douchen te onderschrijven. Bijvoorbeeld Margriet, Quest, RTL Nieuws en Flair.

Ten tijde van publicatie, in 2016, was het NRC al kritisch naar de opzet van het onderzoek:

Dit zijn zeer terechte constateringen die eenieder die het onderzoek aanhaalt zou moeten benoemen. Daarbij is een andere conclusie van het onderzoek dat, hoewel er 29 procent minder ziekteverzuim was na 90 dagen, - dat wil zeggen aantal dagen dat men zich daadwerkelijk ziek meldde- er geen effect was na 30 dagen. Tevens was er geen significante impact op het aantal dagen dat men zich ziek voelde. Een duik in het onderzoek zelf leert ons echter dat er nog veel meer aan schort.

De data

De onderzoeksdata is hier beschikbaar. Zoals gezegd zijn er een aantal gekke dingen mee aan de hand.

Totalen

In totaal tellen we 2426 deelnemers die in alle vier de groepen aan het einde van de rit zijn overgebleven. Namelijk 673 + 611 + 595 + 547 (= 2426), zoals we zien in de onderstaande tabel (Tabel 4 uit het onderzoek), bovenste rij.

Echter, er zijn 2220 proefpersonen meegenomen in de eindresultaten van het onderzoek.

In de groep van 30 seconden ontbreken 87 deelnemers, in de 60-secondengroep 64 deelnemers, 25 ontbreken er in de groep van 90 seconden en in de controlegroep nog eens 30.

Teruglopend aantal verzuimdagen

De deelnemers werd gevraagd het aantal dagen ziekteverzuim door te geven na 30 dagen én na 90 dagen. Logischerwijs is het tweede getal gelijk aan of meer dan het eerste getal. Als je bijvoorbeeld gedurende de eerste 30 dagen 3 keer jezelf had ziekgemeld, is het onmogelijk dat je gedurende de totale 90 dagen - waar die 30 dagen dus bij in zit- maar 2 keer jezelf ziek meldde. Het kan enkel oplopen.

Toch gaven honderden respondenten meer ziektedagen aan na 30 dagen dan na 90 dagen, in totaal zo’n vijf procent. In het geval van aantal dagen ziek voelen is dit zelfs ruim 20 procent. Als je voor deze datapunten het aantal dagen verzuim na 90 dagen gelijk zet als na 30 dagen, heeft dat flinke impact op het eindresultaat: 19 procent minder ziekteverzuim in plaats van 29 procent, met een p-waarde van 0,04 in plaats van 0,003.

Aantal dagen ziekteverzuim

Daarbij is het verloop van het totaal aantal gerapporteerde dagen ziekteverzuim per proefpersoon bijzonder opmerkelijk.

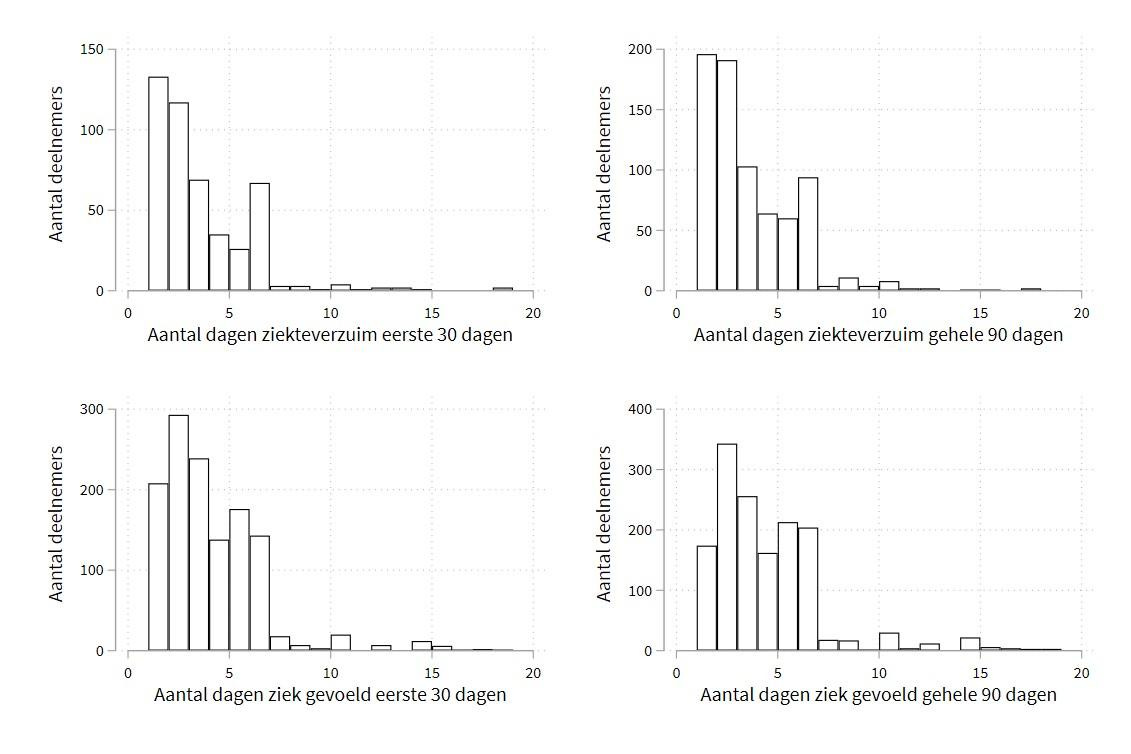

In het onderstaande histogram zien we het aantal proefpersonen per totaal aantal ziekteverzuimdagen. Voor het gemak zijn het aantal respondenten met nul keer en met twintig keer of meer ziekteverzuim weggelaten.

Zoals je ziet is er een gigantische dip, in elke groep, na zes dagen in totaal ziekteverzuim. Dit kan absoluut geen toeval zijn, maar in het disussiegedeelte van het paper blijft het onbenoemd.

Het model

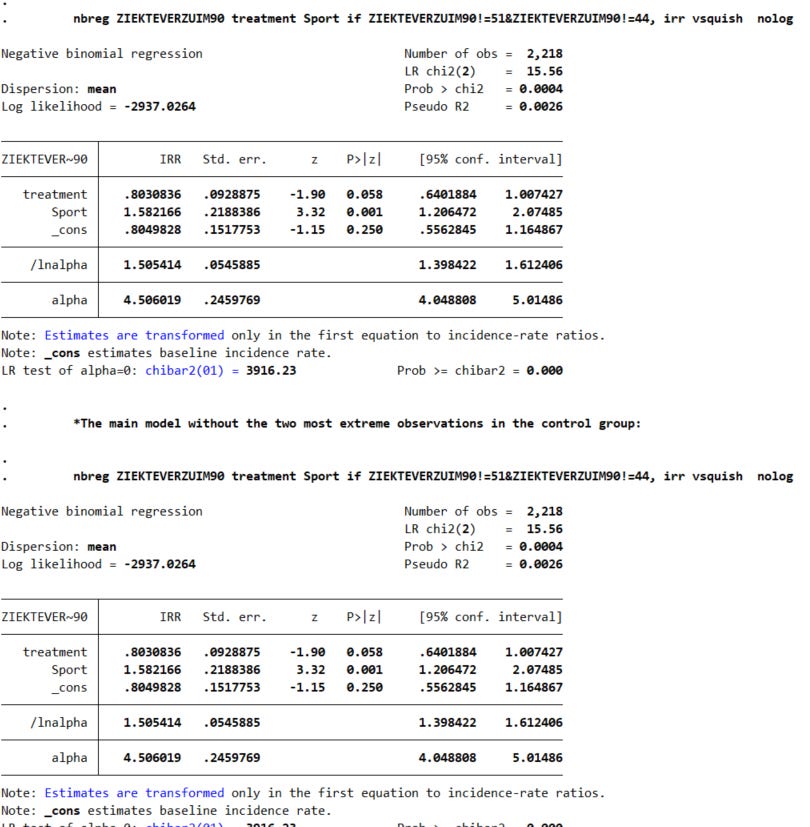

Bij dit soort onderzoeken moet je een statistisch model kiezen dat het beste past bij de aard van je data. De onderzoekers hebben in deze gekozen voor een zogeheten negative binominal regression model. Dat zal de meeste mensen niets zeggen, dus het lijkt me afdoende te melden dat dit voor dit soort data een veelgemaakte keus is. Zo heb ik mij door meerdere artsen en statistici laten vertellen.

Toch moet genoemd worden dat dit specifieke model bijzonder gevoelig is voor extremen en het erop lijkt dat in dit geval dit model de statistische onzekerheid onderschat. Met andere woorden: de uitkomst is veel onzekerder dan dat het lijkt.

Om te illustreren hoe gevoelig dit model is voor uitschieters, berekende Joop het volgende: als we de twee personen met het hoogste ziekteverzuim uit de controlegroep verwijderen, dan zijn de resultaten met p=0,05 niet meer significant. Als we deze individuen aan de behandelgroep toevoegen, zijn de resultaten volkomen onbeduidend.1 Kortom, de nauwkeurigheid van het model wordt overschat.

In het licht van de bovengenoemde problemen met de data, is dat zorgelijk. Er ontbreekt van alles en sommige datapunten kloppen simpelweg niet. Daarbij zaten zes van de tien werknemers die gedurende een periode van negentig dagen het meest afwezig waren op het werk, in de controlegroep

Tel daarbij ook nog eens op dat, zoals eerder aangehaald, de proefpersonen zichzelf moesten aanmelden, wat al een groot risico geeft op het placebo-effect. Maar ook: het nocebo-effect. Een enthousiaste Wim Hof-adept die in de controlegroep terecht was gekomen, zal vast en zeker teleurgesteld zijn geweest.

En ook: een groot deel van de interventiegroep viel af. Deze mensen zouden ziek kunnen zijn geworden en daardoor zijn gestopt met het programma, maar die worden dus niet meegenomen, terwijl dat juist essentiële datapunten kunnen zijn. Dit is een vorm van zogeheten selection bias, namelijk attrition bias, in het Nederlands uitvalsbias.

Het mechanisme

Wat ook de wenkbrauwen doet fronsen, is de manier waarop de conclusie is geformuleerd:

A routine (hot-to-) cold shower resulted in a statistical reduction of self-reported sickness absence but not illness days in adults without severe comorbidity.

Ofwel, koud douchen resulteert in minder ziekteverzuim. Maar dit impliceert causaliteit, terwijl het vooralsnog om een associatie gaat. Nergens in het onderzoek wordt besproken waaróm het koude douchen nou zo’n impact heeft op het ziekteverzuim. En waarom er geen significant verschil was in hoe ziek de proefpersonen zich daadwerkelijk voelden. Deze twee conclusies worden naast elkaar geplempt en vooral de eerste wordt uitvergroot, terwijl ze elkaar juist gevoelsmatig tegenspreken.

Een onderliggend biologisch mechanisme zou moeten verklaren waarom mensen door koud afdouchen zich minder vaak ziek melden, terwijl ze zich niet minder ziek voelen. De gebruikelijke verklaring bij hosanna rondom de Wim Hof Methode, namelijk ‘kou boost het immuunsysteem’, gaat dan niet op.

Niet genoemde belangen

Bij een gepubliceerd onderzoek horen de wetenschappers altijd concurrerende belangen te vermelden, in het kader van transparantie. In deze is het volgende vermeld:

Er zijn volgens deze verklaring dus geen patenten, producten in ontwikkeling of op de markt gebrachte producten om aan te geven in het kader van tegenstrijdige belangen. Dit is twijfelachtig.

Het effect is geëxploiteerd door een bedrijf, genaamd ice.club. Dit bedrijf bood een online programma aan voor koud douchen en stuurde ten tijde van publicatie van het onderzoek een persbericht uit. Via deze link is te zien hoe de website eruitzag voordat deze uit de lucht werd gehaald. Op de website waar mensen zich aan konden melden voor het experiment, stond ook een link naar ice.club.

De eigenaar van dit bedrijf, Linda Koeman, was betrokken bij het onderzoeksteam en ten tijde al Wim Hof-coach. Ze is weliswaar geen co-auteur, maar wordt wel genoemd in het dankwoord en aanvullend document S3 als onderdeel van het onderzoeksteam. Ze heeft enkel ‘logistiek’ bijgedragen. In het kader van transparantie had ook zij vermeld moeten worden in de belangverklaring.

Iemand anders die wordt genoemd in dat document, is Koen de Jong. Hij heeft meegeschreven aan het boek van Wim Hof in 2015 en wordt genoemd als een van de auteurs van het onderzoeksprotocol.

Daarbij blijkt uit eerdere media-optreden van de hoofdauteur Buijze en Wim Hof dat zij een bestaande relatie erop nahielden. Zo verschenen zij in 2014 al gezamenlijk bij Pauw en Witteman.

Zij zaten daar aan tafel met een aantal ernstig zieke patiënten. Ze vertelden over hoe ze samen de Kilimanjaro beklommen, omdat kou, volgens Hof, wonderen doet voor het immuunsysteem en zo dus allerlei kwaaltjes zou kunnen genezen. Buijze zegt hier dat de methode van Wim Hof niet gaat om genezen, maar om de patiënten zich beter en energieker te laten voelen. Destijds was hier al enige ophef over. HP De Tijd schreef:

Volgens het tijdschrift waarin het onderzoek werd gepubliceerd, PLOS ONE, vallen onder concurrerende belangen:

‘Een concurrerend belang is alles dat de volledige en objectieve presentatie, peer review, redactionele besluitvorming of publicatie van onderzoeks- of niet-onderzoeksartikelen die aan PLOS worden ingediend, belemmert, of redelijkerwijs kan worden opgevat als een belemmering. Concurrerende belangen kunnen financieel of niet-financieel, professioneel of persoonlijk zijn. Concurrerende belangen kunnen ontstaan in de relatie tot een instelling, organisatie of een andere persoon.’

Zowel Koeman, De Jong als Buijze vallen onder deze clausule, terwijl er niks over staat vermeld bij de belangenverklaring.

Conclusie

Zo zie je maar weer dat als een onderzoek gepeerreviewd wordt gepubliceerd in een wetenschappelijk journal, het alsnog geen zekerheid is dat het betreffende onderzoek ook daadwerkelijk deugt.

Mochten de auteurs, het AMC of medewerkers van PLOS alsnog met mij of Adema in contact willen komen, staan we daar uiteraard voor open.

Veel dank voor jullie aandacht en tot volgende week.

Vond je dit gratis artikel hartstikke te gek? Overweeg dan een donatie, als je mij financieel wil steunen.

Of beter nog: word lid van de betaalde nieuwsbrief, dan krijg je er iets voor terug :)

Dat kan ook via iDeal, zowel een maandabonnement als een voordelig jaarabonnement. Wel zo handig.

Goed stuk! Mooi zoals de statistische details zijn nageplozen. In 2014 was er een artikel in de Proceedings of the National Academy of Science. Daar is de peer review doorgaans strenger dan bij de PLoS. Dat artikel beschrijft hoe Nijmeegse onderzoekers 24 vrijwilligers rekruteerden. Twaalf van hen werden 10 dagen lang getraind in de Wim Hof Methode. De overige twaalf vormden de controlegroep. Wie bij welke groep terecht kwam was random. De fysiologische metingen lieten naderhand een gunstig effect zien van de Wim Hof Methode. Het grote probleem is natuurlijk dat het onmogelijk is om zulk onderzoek op een gedegen random dubbelblinde manier te doen. Mensen die bereid zijn 10 dagen op te offeren voor instructie in de Wim Hof Methode zijn hoogstwaarschijnlijk mensen die er sowieso al in geloven. Zulke confirmation bias bij de vrijwilligers zou wel eens van grote invloed kunnen zijn. Het zou mooi zijn als dat PNAS artikel op nauwgezette wijze onder de loep genomen zou worden. De statistiek in dat artikel ben ik bijvoorbeeld niet nagegaan.

"Bij dit soort onderzoeken moet je een statistisch model kiezen dat het beste past bij je data."

Even mieren neuken: je zou kunnen zeggen dat je een statistisch model moet kiezen dat het beste bij de *aard* van je data past. Maar data verzamelen, die bekijken (descriptieve statistieken w/e) en daar een statistisch model bij kiezen is niet de bedoeling. En een bron van veel p-hacking in mijn ervaring.